December 12, 2017

Comment analyser vos résultats d'études qualitatives ?

En conclusion de notre série consacrée au livre blanc de la Mobile Marketing Association France sur la Qualité des Applications Mobiles, il nous reste à ce stade un objectif. Il s'agit d’identifier de manière neutre les 5-10 problèmes prioritaires dont la résolution va le plus efficacement améliorer votre application mobile ou par extension votre site internet.

Les techniques d'analyse d'études qualitatives décrites dans cet article sont particulièrement adaptées aux méthodologies d'étude telles que le test utilisateur en ligne appliqué à la conception de sites internet ou d'applications mobiles. Si vous voulez en savoir plus sur l'analyse d'enquête qualitative sur des sujets variés, digitaux ou non, vous pouvez également consulter nos exemples d'accompagnements autour des sujets de connaissance des attentes et comportements des clients.

L'analyse des résultats qualitatifs, un exercice de synthèse

Dans un esprit d’agilité ou simplement d'efficacité, il y a en effet un fort intérêt à résoudre ces cinq à dix problèmes les plus pressants en priorité. Idéalement, vous pourrez ensuite re-tester pour vérifier l’impact, le retour sur investissement de vos actions, puis recommencer ! Ne perdons pas de vue que les tests utilisateurs peuvent facilement générer plus de problèmes à régler qu’il ne sera possible d’en résoudre : autant sélectionner les plus importants.

L'analyse commence par lister les problèmes issus de l'étude qualitative

La lecture des résultats d’un test utilisateurs demande une grande rigueur car il est très tentant d’interpréter les données dans un sens qui renforce nos préjugés au détriment de la neutralité.Cet acte d’interprétation, nous ne le faisons d’ailleurs pas forcément consciemment. Notre cerveau cherche naturellement à conforter ce qu’il sait déjà. Alors, comment rester impartial ?

-

Consulter l’intégralité des retours avant de conclure. Si les trois premiers utilisateurs renforcent nos convictions, rien ne dit que les suivants le feront aussi. Evitez ainsi le biais cognitif de confirmation !

- Identifier chaque problème rencontré par un utilisateur puis compter le nombre de fois que ce problème revient chez cet utilisateur comme les autres.

- Accepter le bruit et lire entre les lignes : si un utilisateur ne voit pas le prix de livraison qui est désormais écrit en corps 36, il envoie un signal. Ce n’est peut-être pas, dans cet exemple, la taille, mais le bon emplacement ou le bon moment pour lui parler du prix de livraison.

- A la fin du processus, regrouper les problèmes par catégorie, bref catégoriser.

La synthèse de l'analyse de l'étude qualitative est un processus simple mais rigoureux

Nous avons maintenant une liste de problèmes rencontrés par les utilisateurs avec une fréquence pour chaque problème. Pour identifier ces problèmes prioritaires, il faut repérer :- Ceux qui reviennent les plus fréquemment.

- Les problèmes critiques : les utilisateurs doivent confirmer leurs adresses email lorsqu’ils s’inscrivent, mais un utilisateur sur dix reçoit l’email de confirmation dans ses courriers indésirables : c’est un problème critique.

- Les “quickwins” : ce sont des problèmes qui prennent quelques minutes à résoudre et permettent des améliorations immédiates. C’est souvent le cas d’un titre, d’un texte à clarifier, d’une traduction manquante, d’un lien cassé...

- Ignorer les problèmes dits “kayak”. Comme lorsqu’un kayak fait un tour complet sur lui-même, certains problèmes perturbent l’utilisateur quelques instants mais ne l’empêchent pas de reprendre sa navigation et de continuer.

- L’exception qui confirme ces règles : si nous avons déjà mené plusieurs tests, nous en savons beaucoup. Nous aurons alors certainement un intérêt à regarder également les retours plus exotiques (problèmes kayaks et problèmes peu fréquents) car nous n’avons plus de problème majeur à résoudre. Nous sommes dans la finition.

En conclusion, peut-on prédire le succès d’une application mobile ?

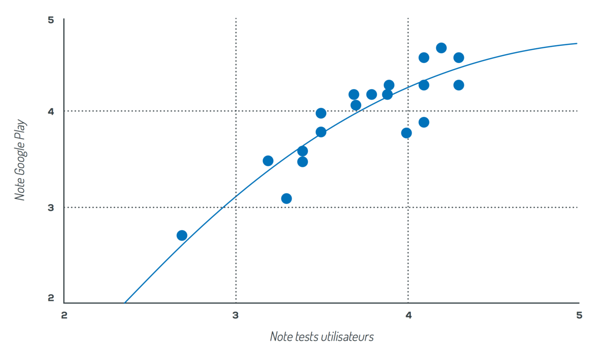

Tester son application n’a de valeur que si les résultats des tests sont en accord avec ce que vont vivre et dire les utilisateurs réels de l’application. Pour mieux comprendre ce sujet peu exploré, nous avons comparé les notes données aux applications lors de tests utilisateurs et leur 20 équivalent sur les stores, une fois l’application publiée. Sur plus de 50 applications, nous avons constaté que les notes données lors de tests étaient “prédictifs” à 0,5 étoiles (soit une marge d’erreur de 10 %) de la note finale sur Play Store et sur l’App Store.Le graphique ci-dessous montre la corrélation sur des applications Android (où la note est plus précise que sur l’App Store). Il est intéressant de noter que l’on retrouve, comme sur l’App Store, un “plafond de verre” autour de 4,7 étoiles sur 5.

Ces premières données, qui doivent être approfondies, laissent à penser que les tests peuvent effectivement prédire la note que les utilisateurs vont donner aux applications, fournissant aux décideurs une meilleure vision de l’accueil que recevra leur application mobile au lancement.

Notes Google Play corrélées aux notes de tests utilisateurs

Cet article vous a plu ? Rendez-vous sur le site de la Mobile Marketing Association France pour télécharger le livre blanc des bonnes pratiques du test d’application mobile.

Envie d'en savoir plus sur les études Ferpection ? Retrouvez nos solutions d'analyse et d'écoute des utilisateurs sur notre site.

Tous les articles de la catégorie : Recherche utilisateur | RSS