October 12, 2018

5 utilisateurs suffisent-ils vraiment pour réaliser vos tests utilisateurs de sites et applications mobiles ?

Dans un article fondateur publié en 2000 intitulé

« Why You Only Need to Test with 5 Users

», Jakob Nielsen nous explique comment il suffit d'interroger 5 personnes pour réaliser un test utilisateurs. Ce nombre magique est-il toujours aussi pertinent ? Dans cet article, je vous propose une relecture de la formule mathématique qui a conduit le co-fondateur du Nielsen Norman Group (NNG) à obtenir ce résultat.

Résumé de cet article en une phrase : en se basant sur la formule proposée par Jakob Nielsen, vous obtiendrez une vision plus exhaustive des problèmes d'UX avec 30 utilisateurs à distance qu'avec 5 utilisateurs en présentiel. Mais prenons notre temps !

De petits tests utilisateurs, en grand nombre !

Nielsen Norman Group répète sans relâche que, certes 5 personnes suffisent, mais il faut en revanche absolument conduire des tests répétés. L'un des arguments phare est lié au fait que votre projet est vivant. Il s'agit donc de l'éprouver à différents stades de son évolution. Il faut aussi dire que les études permettent d'identifier des barrières mais que les solutions que vous y apportez méritent également d'être validées. Il s'agit donc de répéter les phases d'écoute jusqu'à éliminer un maximum d'incertitude.Un précepte que nous avons fait nôtre chez Ferpection avec le découpage des stratégies d'étude par grandes étapes :

Cette nécessité de tests répétés est l'une des trois hypothèses sous-jacentes au modèle proposé dans l'article sus-cité. Dans la suite de cet article, nous allons regarder deux autres hypothèses et les challenger du fait de l'incroyable évolution du web en quelques années.

Ce que dit vraiment la formule du nombre d'utilisateurs de Jakob Nielsen

Première étape de notre relecture, commençons par réviser nos classiques. Qu'est-ce que cette fameuse formule ? En réalité, derrière l'article publié sur le site de NNG, il y a une publication académique de 1993 : "A Mathematical Model of the Finding of Usability Problems". Les auteurs en sont - surprise - Jakob Nielsen et Thomas K. Landauer. Reprenant les résultats de plusieurs tests utilisateurs d'interface logiciels, ils montrent empiriquement que le nombre de problèmes que peut révéler une étude suit une forme d'asymptote, plus connue sous le nom de loi de Poisson. La formule mathématique de cette loi est bien connue (attention, ça va devenir un peu technique mais pas longtemps rassurez-vous).La formule permet de connaître le nombre de problèmes d'UX en fonction du nombre n d'individus interrogés :

Où :

- N est le nombre total de problèmes dans l'interface,

- L est la proportion de problèmes trouvés par un individu unique.

Mais pourquoi donc 5 utilisateurs ?

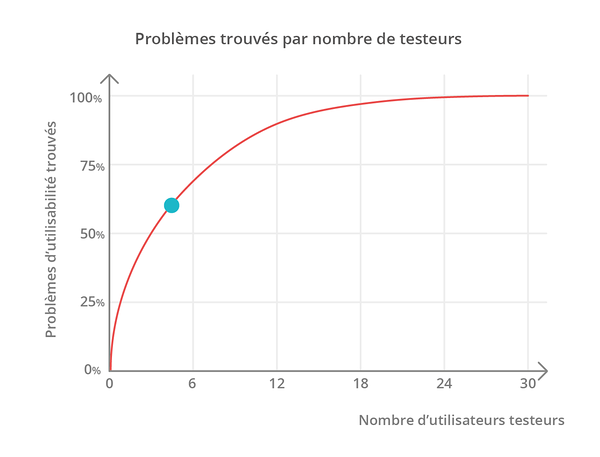

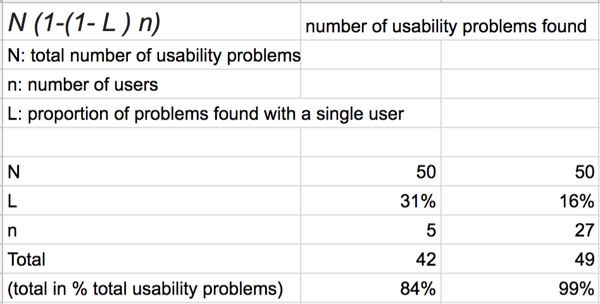

Vous avez survécu jusque là ? Tant mieux car la suite est plus simple ! En 2000, donc sept années plus tard, Jakob Nielsen va opérer une simplification et conclure dans son article resté célèbre que 5 utilisateurs suffisent pour écouter vos visiteurs. Plus exactement, il montrera en utilisant la formule qu'avec 5 utilisateurs, vous trouverez 84% des problèmes d'UX dans une interface donnée.Pourquoi seulement 84% me direz-vous ? A cause de deux hypothèses qui ne sont peut-être plus aussi pertinentes qu'en 1993 :

- Avec son complice Thomas Landauer, il a calculé le ratio optimum entre le coût d'une étude et le nombre d'interviewés sur la base d'un budget d'étude compris entre 6.000$ et 10.000$ pour 5 utilisateurs. Hors de nos jours, grâce à internet, ce même budget permet d'interroger 30 personnes lors d'un test utilisateurs à distance. Ce ratio coût / interviewés n'a donc plus vraiment de sens.

- Ils supposent également qu'un individu va trouver 31% de tous les problèmes d'UX liée à une interface sur un logiciel tournant sur un système d'exploitation et une faible diversité des écrans. Encore une fois, de nos jours, la fragmentation des écrans et des systèmes augmente le nombre de problèmes spécifiques à micro-segments d'utilisateurs. Le ratio de 31% est donc sur-estimé. Graphiquement, cela signifie que la courbe est trop haute. Avec une hypothèse plus réaliste de 16% (voir ci-dessous), l'on ne trouverait que 58% des problèmes, là où se situe la cible bleue.

Mais combien d'utilisateurs faut-il interroger alors, si ce n'est pas au nombre de cinq ?

Nous allons relire la formule permettant de trouver le nombre idéal d'utilisateurs en mettant à jour les hypothèses sous-jacentes :- Maximiser le pourcentage de problèmes découverts. Comme notre courbe suit une asymptote, nous ne pouvons pas espérer 100% et nous contenterons de trouver 99% des problèmes.

- Diviser par deux le pourcentage (15,5%) de problèmes trouvés par un individu seul du fait de la fragmentation des écrans mais aussi car nous considérons que les utilisateurs réaliseront un test à distance post-modéré. Ces tests ont la réputation d'être moins profonds bien que cela ne soit pas prouvé scientifiquement. Un papier de recherche sur ce sujet montre qu'un test à distance peut révéler pratiquement 100% des problèmes critiques identifiés par un animateur qualitativiste sur ce même test.

Sur cette base, le nombre idéal d'utilisateurs est de 27. Dans le tableau ci-dessous, vous retrouvez la formule avec dans la colonne de gauche les hypothèses de Jakob Nielsen et dans la colonne de droite les hypothèses revisitées ici :

De 5 utilisateurs à 27 et enfin à 30 !

Nous arrivons à la fin de notre relecture. Si interroger 27 personnes suffira, il y a deux bonnes raisons d'arrondir ce chiffre à 30 personnes :- La première est purement psychologique. De la même manière que le chiffre optimal découvert à l'époque par Thomas Landauer était en réalité de 4 et non 5, il semble plus simple de communiquer sur un échantillon de 30 personnes même si cela n'a rien de mathématique.

- La deuxième est liée à l'exploitation des résultats de manière statistique. En dessous de 30 individus, la Loi normale ne s'applique plus. Hors la loi normale nous autorise notamment à réaliser des fréquences, des moyennes et donc à peser le poids de chacun des problèmes remontés par les utilisateurs. En dessous de ce nombre, il faudra prendre tout calcul avec des pincettes car il s'agira d'un échantillon dit faible ou non-paramétrique. En particulier, toute personne se livrant à des calculs sur un échantillon de 5 ou même 10 personnes prend d'énormes risques en termes d'interprétation.

Oui mais parfois 5 users c'est bien aussi non ?

Tout à fait car identifier 84% des freins rencontrés par vos utilisateurs et clients peut se révéler être un résultat tout à fait honorable. Cela se produit notamment lorsque des ciblages spécifiques conduisent à des coûts de recrutement plus proches de ceux constatés par Nielsen et Landauer en 1993. Plus précisément chez Ferpection, nous avons adopté deux tailles d'échantillon intermédiaires :- Entre 5 et 10 utilisateurs pour des cibles sur mesure, comme des fonctions spécifiques en entreprises ou les clients d'une marque relativement pointue. Nous restons dans ce cas proche des ratios d'efficacité donnés par Nielsen Norman Group.

- Entre 15 et 20 utilisateurs pour des cibles recrutés avec des critères de ciblage très particulier comme un type d'achat en ligne spécifique, l'usage dans la durée d'une application particulière, etc. A coût égale, nous trouverons ainsi entre 92% et 97% des difficultés liées à l'expérience utilisateurs.

Et si je double l'échantillon avec un nombre de 60 utilisateurs ?

Avec 60 utilisateurs, vous doublez forcément les moyens mis en place - temps et argent - pour un gain de 0,9% de problèmes trouvés. A vous de voir donc.En conclusion, le contexte ayant évolué depuis 1993, lorsque le ciblage le permet, il est désormais pertinent de remplacer des échantillons de 5 utilisateurs en présentiel par des échantillons de 30 personnes à distance afin d'identifier l'ensemble des problèmes d'UX et de les prioriser avec confiance.

Pour en savoir plus :

Why You Only Need to Test with 5 Users

Vous souhaitez en apprendre davantage sur les différentes méthodes de recherche utilisateur à disposition pour mieux comprendre vos utilisateurs et tester vos produits et services ? Rendez-vous sur notre page méthodologies d'études UX research.

Tous les articles de la catégorie : Recherche utilisateur | RSS